Robots.txt là gì? Vai trò của robots.txt trong SEO là gì?

Nếu bạn là một người làm SEO hay quản trị website, chắc hẳn bạn đã từng nghe đến thuật ngữ robots.txt. Đây là một công cụ hữu ích để kiểm soát cách các robot tương tác với website của bạn. Nhưng robots.txt là gì? Nó có vai trò gì trong SEO? Làm sao để viết và sử dụng robots.txt hiệu quả? Bài viết này sẽ giúp bạn giải đáp những câu hỏi trên.

Robots.txt là gì?

Tệp robots.txt là một tệp tin văn bản đơn giản nằm trong thư mục gốc của website, cung cấp hướng dẫn cho các robot thu thập dữ liệu web về các trang mà họ có thể hoặc không thể thu thập thông tin để lập chỉ mục.

Cấu trúc và cách viết robots.txt

Robots.txt là một phần của Robots Exclusion Protocol (REP) chứa một nhóm các tiêu chuẩn web.

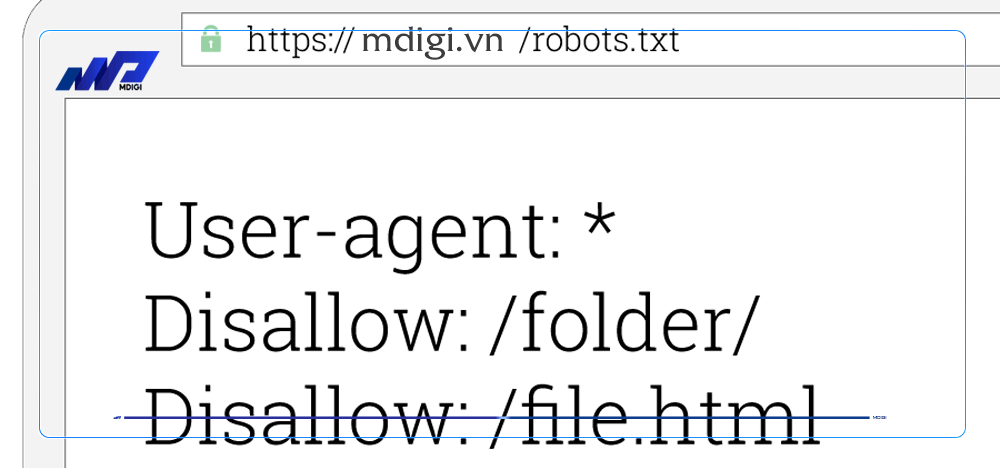

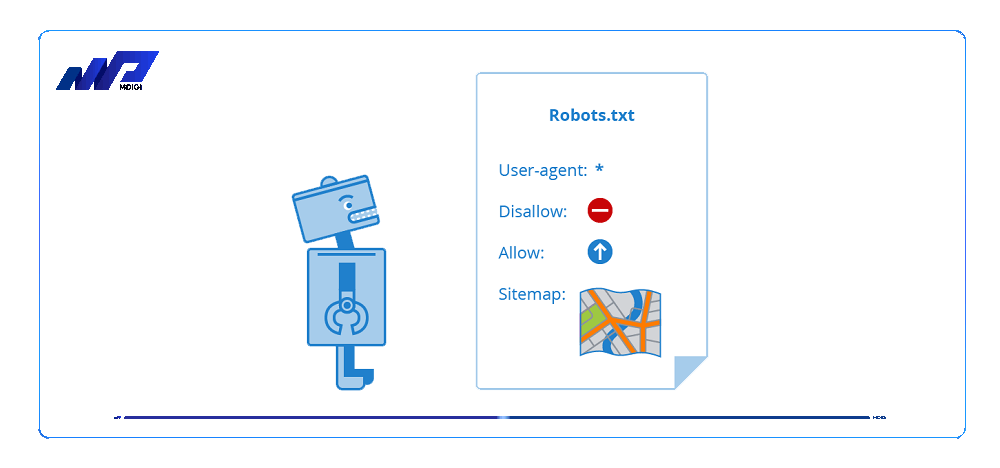

Cấu trúc tệp gồm hai phần chính: User-agent và Disallow.

- User-agent là trình thu thập dữ liệu của website. Nếu bạn muốn thu thập tất cả các nguồn thông tin, bạn sử dụng câu lệnh User-agent*. Trong trường hợp bạn muốn chỉ định tên của trình thu thập thì dùng câu lệnh User-agent: + tên trình thu thập (Googlebot, Bingbot, Ahref…)

- Disallow là hướng dẫn cho User-agent không thu thập dữ liệu của bất cứ URL nào trên website. Mỗi một URL sẽ chỉ được dùng một dòng disallow duy nhất.

Ngoài ra, có thể sử dụng thêm các lệnh khác như Allow (cho phép Googlebot được truy cập những trang và thư mục con được phép truy cập), Crawl-delay (thời gian chờ cho các crawler), Sitemap (sơ đồ của trang web và được liên kết với những URL tương ứng).

Để viết tệp, bạn có thể sử dụng bất kỳ công cụ soạn thảo văn bản nào như Notepad hay Wordpad. Sau khi viết xong, bạn lưu lại file với tên là robots.txt và upload lên thư mục gốc của website. Bạn có thể kiểm tra file bằng cách gõ địa chỉ website của bạn kèm theo /robots.txt. Ví dụ: https://example.com/robots.txt.

Ví dụ về nội dung chuẩn

Dưới đây là một số ví dụ về nội dung của robots.txt cho các trường hợp khác nhau:

- Ví dụ 1: Chặn toàn bộ website khỏi các crawler

User-agent: *

Disallow: /

- Ví dụ 2: Cho phép toàn bộ website được crawl

User-agent: *

Disallow:

- Ví dụ 3: Chặn một số URL hoặc thư mục khỏi crawler

User-agent: *

Disallow: /login

Disallow: /admin

Disallow: /cart

- Ví dụ 4: Cho phép chỉ một số crawler được truy cập vào website

User-agent: Googlebot

Disallow:

User-agent: *

Disallow: /

- Ví dụ 5: Thêm sitemap vào robots.txt

User-agent: *

Disallow:

Sitemap: https://example.com/sitemap.xml

Công cụ kiểm tra tệp Robots.txt

Trình kiểm tra robots.txt của Google Search Console

Công cụ chính thức của Google cho phép bạn kiểm tra xem tệp robots.txt của bạn có chặn trình thu thập dữ liệu web của Google khỏi một số URL cụ thể trên trang web của bạn hay không.

Bạn cần đăng nhập vào Google Search Console và chọn website của bạn để sử dụng công cụ này. Sau đó, bạn nhập URL của một trang trên website của bạn vào hộp văn bản ở cuối trang và chọn tác nhân người dùng mà bạn muốn mô phỏng.

Nhấp vào nút KIỂM TRA để xem kết quả. Bạn cũng có thể chỉnh sửa tệp robots.txt trên trang và kiểm tra lại nếu cần thiết, nhưng nhớ rằng những thay đổi này sẽ không được lưu vào website của bạn. Bạn cần phải sao chép và dán nội dung từ trình chỉnh sửa vào tệp robots.txt trên website của bạn.

Trình kiểm tra & xác minh Robots.txt của Website Planet

Công cụ miễn phí và dễ sử dụng cho phép bạn kiểm tra tính chính xác và không lỗi của tệp robots.txt của bạn. Chỉ cần nhập URL website đầy đủ của bạn, theo sau là /robots.txt (ví dụ: yourwebsite.com/robots.txt) và nhấp vào nút KIỂM TRA. Công cụ này sẽ tìm thấy mọi lỗi (chẳng hạn như lỗi đánh máy, cú pháp và lỗi ‘logic’) cũng như cung cấp cho bạn các mẹo để tối ưu hóa tệp robots.txt của bạn.

Hướng dẫn tạo file Robots.txt cho WordPress

Nếu website của bạn được xây dựng bằng WordPress, bạn có thể sử dụng một số plugin để tạo và chỉnh sửa tệp Robots.txt cho website của bạn.

Một số plugin phổ biến là Yoast SEO, Rank Math SEO, All in One SEO Pack… Bạn cần cài đặt và kích hoạt plugin trên website của bạn, sau đó tìm đến phần quản lý tệp robots.txt trong plugin.

Bạn có thể viết hoặc chỉnh sửa nội dung của tệp robots.txt theo ý muốn và lưu lại. Bạn cũng có thể kiểm tra tệp robots.txt bằng các công cụ khác để đảm bảo rằng nó không chặn các trang quan trọng hoặc cho phép các trang nhạy cảm.

Hướng dẫn sử dụng và chỉnh sửa tệp Robots.txt

Bước 1: Tạo tệp robots.txt bằng trình soạn thảo văn bản đơn giản như Notepad hoặc Wordpad, lưu lại tệp với tên là robots.txt và đặt nó trong thư mục gốc của website của bạn.

Bước 2: Viết nội dung cho tệp robots.txt theo cú pháp sau:

User-agent: [tên robot thu thập dữ liệu web]

Disallow: [URL không cho phép thu thập dữ liệu]

Allow: [URL cho phép thu thập dữ liệu]

Sitemap: [đường dẫn đến tệp sitemap của website]

Bước 3: Sử dụng các lệnh Disallow và Allow để chỉ định những trang nào bạn muốn chặn hoặc cho phép các robot thu thập dữ liệu web truy cập. Bạn có thể sử dụng ký tự đại diện (*) để ám chỉ bất kỳ chuỗi ký tự nào và ký tự kết thúc ($) để ám chỉ phần cuối của URL. Ví dụ:

User-agent: *

Disallow: /admin/ # chặn toàn bộ thư mục admin

Disallow: /private*.html # chặn tất cả các trang có tên bắt đầu bằng private

Disallow: /product.php?id=123 # chặn trang sản phẩm cụ thể

Allow: /product.php # cho phép trang sản phẩm chung

Allow: /public/ # cho phép toàn bộ thư mục public

Bước 4: Sử dụng lệnh Sitemap để chỉ định vị trí của tệp sitemap của website của bạn. Tệp sitemap là một tệp XML chứa danh sách các URL của website của bạn và giúp các robot thu thập dữ liệu web hiểu được cấu trúc và nội dung của website của bạn. Ví dụ:

Sitemap: https://example.com/sitemap.xml

Bước 5: Kiểm tra tệp của bạn bằng các công cụ như Trình kiểm tra robots.txt của Google Search Console, Trình kiểm tra & xác minh Robots.txt của Website Planet, hoặc các plugin WordPress như Yoast SEO, Rank Math SEO, All in One SEO Pack… để đảm bảo rằng tệp của bạn không có lỗi cú pháp, logic hoặc chặn nhầm các trang quan trọng hoặc cho phép các trang nhạy cảm.

Câu hỏi thường gặp

Tệp có vai trò quan trọng trong SEO vì nó giúp bạn kiểm soát cách các robots tương tác với website của bạn, chẳng hạn như chặn hoặc cho phép các robot truy cập vào một số khu vực nhất định trên website. Tệp này cũng có thể giúp bạn tối ưu hóa SEO bằng cách tiết kiệm tài nguyên crawl từ các công cụ tìm kiếm, tránh bị phạt do nội dung trùng lặp hoặc nhạy cảm.

Để viết và sử dụng tệp robots.txt hiệu quả, bạn cần tuân theo các quy tắc sau:

– Viết bằng công cụ soạn thảo văn bản đơn giản như Notepad hay Wordpad, lưu lại file với tên là robots.txt và upload lên thư mục gốc của website.

– Sử dụng cú pháp đúng đắn gồm User-agent và Disallow, có thể kết hợp với các lệnh khác như Allow, Crawl-delay, Sitemap để tùy biến theo nhu cầu.

– Kiểm tra tệp bằng Trình kiểm tra robots.txt của Google Search Console để xem liệu tệp của bạn có chặn trình thu thập dữ liệu web của Google khỏi một số URL cụ thể trên trang web của bạn hay không.

– Cập nhật và kiểm tra lại tệp thường xuyên để đảm bảo rằng nó không chặn các trang quan trọng hoặc cho phép các trang nhạy cảm.

Kết luận

Robots.txt là một công cụ hữu ích để kiểm soát cách các robot tương tác với website của bạn. Tệp có cấu trúc đơn giản gồm User-agent và Disallow, có thể kết hợp với các lệnh khác để tùy biến theo nhu cầu. Nó có thể giúp bạn tối ưu hóa SEO bằng cách tiết kiệm tài nguyên crawl từ các công cụ tìm kiếm.

Tuy nhiên, bạn cũng cần lưu ý rằng robots.txt không thể buộc các robot tuân theo các chỉ thị của nó, và không thể chặn hoàn toàn các trang khỏi việc được index bởi các công cụ tìm kiếm. Do đó, bạn nên sử dụng robots.txt một cách cẩn thận và kết hợp với các công cụ khác như meta tag, Google Search Console để quản lý website hiệu quả hơn.

Bài viết liên quan

Lưu ý:

*Thông tin trong bài viết đều là những kiến thức chuyên môn và kinh nghiệm thực tế của đội ngũ sáng tạo tại MDIGI . Mọi hành vi sao chép vui lòng ghi trích dẫn nguồn MDIGI.vn! Xem Điều khoản & điều kiện của Chúng tôi.

*Cập nhật mới nhất ngày: 08/08/2023